比较两组或多组数据之间是否存在差异,以及差异是否具有统计学意义。

t检验

t检验是基于t分布的统计理论,处理两个总体间的计量资料之间的差异。

方差分析

当我们处理多个总体之间的比较的时候,t检验就已经无能为力了。R.A Fisher就发明了一种处理K个总体间计量变量比较方法——方差分析。方差分析是用变异的思想,将总的变异分为组间变异和组内变异,组内变异往往是个体变异导致,一般不会太大;而组间变异除了个体变异外,还有组间干预措施导致的变异,因此,R.A. Fisher认为,如果组间的变异除以组内的变异,结果远远的大于1,就有理由认为,组间的干预措施在发挥着作用,为了纪念Fisher,这种方法简称F检验。

卡方检验

t检验和F检验是用于比较组间计量资料的。计数资料组间比较采用的方法是卡方检验。该检验被誉为二十世纪科学技术所有分支中的20大发明之一,它的发明者是卡尔·皮尔逊(Karl Pearson)。其基本思想是真实值与理论值的吻合程度,简单到不难理解。

虽然独立样本t检验和方差分析都是要求自变量为定类,但是卡方检验自变量的组别仅仅为两组,方差分析的自变量组别可以是两组以上。

统计分析三级,初级说一说,中级比一比,高级找关系。找关系的核心就是建立模型,构建变量之间的数量依存关系,以便进行预测或者控制。

找到关系有几个用处:第一,发现规律,如多因素线性回归模型中的回归系数,可以衡量各个因素的重要性;第二,预测未来,有了公式化的模型,就可以代入可以控制的变量而得到未来期望的因变量。

回归分析常用的回归有:线性回归(一元、多元)、Logistic回归。

线性回归分为解释性回归与预测性回归,解释性回归用于阐明几个自变量对因变量的作用大小,更是从专业的角度去理解模型,一些P>0.05的变量依据专业可以进入模型,常采用输入法。预测性模型是为了有更好的预测效果,也就是在统计学上追求最佳的模型,此时常采用逐步回归法。

线性回归要求因变量Y为连续性变量,自变量X可以是连续性,也可以是二分类、等级或无序多分类,当是无序多分类时,需要设置哑变量。

一个好的模型,不仅仅是统计学上的最佳模型,更需要得到专业上的可解释。

R方是衡量模型解释度的指标,一般在描述性研究,简单回归中,R2>0.5较好,>0.8就非常好;多重回归>0.3尚可,>0.5良好,>0.6非常好;但对于实验性研究,>0.8以上才有应用的价值。

Logistic回归适用于预测结果是二分类问题,如发病(y =1)与不发病(y =0)。本质上跟线性回归差不多,只是需要多做一个logit变换。

时间序列时间序列适用于指标数量少的情况,特别是只有一个DAU/销售量的情况。

平滑:用于相对平稳的数据。

自回归:用于趋势性递增、递减的数据。

带季节因素自回归:用于有周期性波动的数据。

探索性分析聚类

理想的聚类,首先应该稳定,并且专业上很好解释。同时在聚类图上,有一个特点,就是组间的差异很大,而组内的差异较小。

主成分分析

其实就是对变量进行聚类。可用于指标降维。

统计谬误相关≠因果

人们常常将相关性和因果关系混淆。举个很简单的例子,一个小朋友从8岁到18岁,身高和体重强相关,但我们不能说身高是由体重决定的。身高和体重都与小朋友的年龄相关,随着他年龄的成长而增长了身高和体重。

辛普森悖论

这个悖论一句话总结,就是每个部分都很好的情况下,总体反而更糟糕。一般案例中,当每组数据对比与整体数据给出不同的结果时,我们就称之为辛普森悖论。如此命名是因为它是由爱德华·辛普森(Edward Simpson)于1951年描述的。然而,同样的观念早在1900年就被苏格兰统计学家乔治·尤尔(George Yule)准确地描述过。

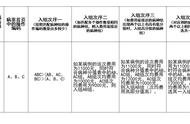

举个例子,下边是某个病症的治愈率,从整体情况看,旧方法整体的治愈率为42÷90=46.7%,新治疗方法整体的治愈率为42÷110=38.2%。总体而言,旧的治疗方法有更高的治愈率。