显然y=WX b这个函数,就是2维/3维/更高维空间的直线/平面/超平面。如果没有偏置项b,则只能在空间里画过原点的直线/平面/超平面。

因此对于逻辑回归必须加上偏置项b,才能保证分类器可以在空间任何位置画决策面。

(2)神经网络偏置项同理,对于多个逻辑回归组成的神经网络,更要加上偏置项b。

如果隐层有3个节点,那就相当于有3个逻辑回归分类器。这三个分类器各画各的决策面,那一般情况下它们的偏置项b也会各不相同。

复杂决策边界由三个隐层节点的神经网络画出如下:

如何机智的为三个分类器(隐节点)分配不同的b呢?或者说如果让模型在训练的过程中,动态的调整三个分类器的b以画出各自最佳的决策面呢?

那就是先在X的前面加个1,作为偏置项的基底,(此时X就从n维向量变成了n 1维向量,即变成 [1, x1,x2…] ),然后,让每个分类器去训练自己的偏置项权重,所以每个分类器的权重就也变成了n 1维,即[w0,w1,…],其中,w0就是偏置项的权重,所以1*w0就是本分类器的偏置/截距啦。这样,就让截距b这个看似与斜率W不同的参数,都统一到了一个框架下,使得模型在训练的过程中不断调整参数w0,从而达到调整b的目的。

所以,如果在写神经网络的代码的时候,把偏置项给漏掉了,那么神经网络很有可能变得很差,收敛很慢而且精度差,甚至可能陷入“僵死”状态无法收敛。

3、误差项定义银行的目标得让误差越小越好,这样才能够使得我们的结果是越准确的。

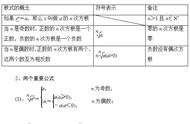

- 真实值和预测值之间肯定要存在差异——用 ε 来表示该误差。

- 对于每个样本:y(i) = θTx(i) ε(i) ,y(i)是真实值,θTx(i)是预测值, ε(i)是差异值。

- 每一个样本的误差值是不同的:

独立同分布(iid,independently identically distribution)在概率统计理论中,指随机过程中,任何时刻的取值都为随机变量,如果这些随机变量服从同一分布,并且互相独立,那么这些随机变量是独立同分布。

- 误差ε(i)是独立且具有相同分布,并且服从均值为0方差为θ2的高斯分布;

- 独立:张三和李四一起来贷款,他俩没有关系,即每个样本到拟合平面的距离都不相同;

- 同分布:他俩都来得是我们假定的同一家银行,所以它在预测的时候是按照同样的方式,数据是在同一个分布下去建模,尽可能来自相同的分布;

- 高斯分布:银行可能会多给,也可能会少给,但是绝大多数情况下,这个浮动不会太大,极小情况下浮动会比较大(有的多有的少,大概来看,均值为0)。

误差在0附近浮动的可能性较大,正负差距较大的可能性越来越小。符合概率统计中现实分布情况。