必须越小越好。

现在就将目标转换为求解最小二乘法。

二、求解最小二乘法从上面的推导可以得出结论:要求让似然函数越大越好,可转化为求θ取某个值时使J(θ)最小的问题。

求解最小二乘法的方法一般为两种:矩阵式、梯度下降法。

1、矩阵式求解数据集含有m个样本,每个样本有n个特征时:

- 数据x可以写成m*(n 1)维的矩阵( 1是添加一列1,用于与截断b相乘);

- θ则为n 1维的列向量( 1是截断b);

- y为m维的列向量代表每m个样本结果的预测值。

矩阵式的推导如下所示:

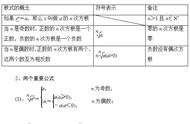

让J(θ)对θ求偏导,当偏导等于零时,则这个θ就是极值点。XT代表X矩阵的转置,XT与X的乘积一定会得到一个对称阵。

另外存在公式: θTXTXθ 等于 2XTXθ。

XTX的逆矩阵为:(XTX)-1 ,将这个逆矩阵分别乘到偏导结果等式两边,左边期望是零,推导得到:

0 = θ - (XTX)-1 · XTy,转换等式得到:θ=(XTX)-1XTy

这种方法存在的问题:不存在学习的过程;矩阵求逆不是一个必然成功的行为(存在不可逆);

2、梯度下降法(GD)目标函数:

对于多元线性回归来说,拟合函数为: